La calidad de los datos se ha convertido en una palanca esencial para el desarrollo de la actividad de una empresa, aunque los últimos avances digitales no se solapen con su actividad principal. Un estudio realizado por IBM arroja la siguiente cifra: ¡la gestión inadecuada de los datos le costó a la economía estadounidense más de 3 billones de dólares en 2016!

Esta asombrosa estimación muestra claramente los beneficios que se obtienen de una gestión eficaz, exhaustiva y continua de la calidad de sus datos. Diferentes herramientas están disponibles en el mercado para satisfacer estas diferentes necesidades de procesamiento, actualización y limpieza. Independientemente del tipo de solución elegida, lo más importante es conocer el buenas prácticas en calidad de los datos y para poder llevar a cabo una auditoría de rendimiento de la gestión de estos datos.

SAS es un completo software de gestión de datos que permite la creación y gestión de bases de datos, el tratamiento analítico de las mismas y la creación y distribución de informes de síntesis y listados. Grandes empresas lo utilizan, como Honda, Bank of America o la ONG WWF.

Puntos fuertes :

- Herramientas completas para grandes empresas

- Apto para todos los sectores de actividad

Precio :

- Desde 7.000 euros/año para la funcionalidad básica hasta varios cientos de miles de euros/año

2. Informatica

Informatica ofrece varias soluciones dedicadas a la integración, el análisis y la mejora de la calidad de los datos. La empresa también ofrece servicios de almacenamiento de datos en la nube. También ofrece una solución SaaS.

Puntos fuertes :

- Puede integrarse con muchas fuentes de datos

- Facilidad de uso y mantenimiento.

Precio :

- Dependiendo del número de características.

3. Melissa

Melissa es una herramienta dedicada a la verificación de datos (identidad, dirección, teléfono, correo electrónico) que es esencial para mantener la calidad de los datos. También ofrecen servicios en torno a la localización y los datos demográficos.

Puntos fuertes :

- Puede combinarse con otras herramientas internas(solución deemailing, CRM…)

- Dispone de soluciones SaaS

Precio :

- A petición

4. Oceanos

Oceanos diseña estrategias de gestión de datos que optimizan el rendimiento de las ventas y el marketing. La herramienta puede integrarse con un archivo CRM y permite puntuar el nivel de calidad de los datos y limpiar, actualizar, enriquecer y analizar los datos.

Puntos fuertes :

- Numerosas integraciones posibles (API, Zapier, Salesforce…)

Precio :

- 1500 a 9500 por mes

Sommaire

2. Preparación de datos

La preparación de los datos incluye todas las etapas de limpieza de los datos para garantizar su coherencia y calidad. La preparación incluye, por ejemplo, la fusión de varias fuentes de datos, el filtrado de datos innecesarios, la consolidación, la agregación de datos y el cálculo de valores adicionales basados en los datos brutos. La preparación es importante porque los datos incoherentes y de mala calidad pueden distorsionar la información resultante. También puede hacer que el análisis y la extracción de datos sean lentos y poco fiables. Al preparar los datos con antelación, las empresas pueden aprovechar mejor todo su potencial.

5. Preparación de datos de Google

Cloud Dataprep es un servicio visual inteligente para explorar, limpiar y preparar los datos para el análisis que funciona sin un servidor. Puede importar varios archivos, fusionarlos, limpiarlos, enriquecerlos, normalizarlos…

Puntos fuertes :

- Fácil de usar

Precio :

- Una media de 3 euros por hora de uso

6. Preparación de datos Talend

Talend Data Preparation es una solución de preparación de datos con 3 paquetes diferentes: un software gratuito y de código abierto, una descarga de pago y una solución de pago en la nube.

Puntos fuertes :

- Es posible una solución para cada tipo de necesidad

Precio :

- A petición

7. Dataiku

Dataiku es una herramienta de análisis de datos, utilizable tanto por ingenieros como por vendedores, potente para la preparación de datos. La interfaz es sencilla e interactiva, por lo que resulta fácil de usar para los profesionales del marketing, y lo suficientemente avanzada y técnica para atraer a los ingenieros de datos.

Puntos fuertes :

- Interfaz sencilla e intuitiva para ingenieros y vendedores

Precio :

- Una versión básica gratuita

- A petición de una versión más completa

8. Qlik Sense

Qlik sense es una herramienta especialmente adecuada para los no iniciados. La interfaz es muy visual y el análisis se ve facilitado por las sugerencias automáticas. Su carácter lúdico hace que la información sea accesible a todas las profesiones de la empresa. Puede ver una demostración de 60 segundos en este vídeo.

Puntos fuertes :

- Puede ser utilizado por todos los negocios de la empresa

- Interfaz sencilla y divertida

Precio :

- Una versión básica gratuita

- Hecho a medida para una mayor funcionalidad

9. Octolis

DataValidation es una de las soluciones de limpieza de correo electrónico más potentes del mercado. Le permitirá identificar las direcciones de correo electrónico no válidas para que no se le considere un spammer durante sus campañas de envío de correos electrónicos.

Puntos fuertes :

- Fácil de usar

- Exactitud de los resultados

Precio :

- 70 por 10.000 correos electrónicos verificados, 300 por 100.000 correos electrónicos

12. 76310

La solución 76310 está especializada en el control y la corrección de direcciones postales y cumple la norma RNVP para el tratamiento informático de las direcciones postales y está homologada por La Poste SNA (servicio nacional de direcciones).

Puntos fuertes :

- Interfaz disponible para el procesamiento de RNVP

- Software de procesamiento, traslado y deduplicación de RNVP

- Aprobado por el SNA

Precio :

- Para 10.000 direcciones (uso en modo SaaS) – 200 euros

- Para 100.000 direcciones (uso en modo SaaS) – 400 euros

- Suministro de software in situ – de 16.000 € HT / año a 30.000 € HT / año

13. Egon

Egon es uno de los programas informáticos líderes en el mercado internacional para la normalización de diversos datos personales (nombre, fecha de nacimiento, títulos, números de teléfono, correo electrónico, código fiscal, número de IVA, datos bancarios, datos postales, código postal, nombres extranjeros, documentos de identidad)

Puntos fuertes :

- Amplia selección de datos a normalizar

- Solución completa de validación de datos

Precio :

- A petición

Auditoría de la calidad de los datos

Si los datos son el combustible de su negocio, especialmente de sus departamentos de marketing y ventas, entonces esos datos tienen que ser de buena calidad. Trabajar con datos de mala calidad genera todo tipo de costes y puede contribuir a que se tomen malas decisiones estratégicas.

¿Cómo crear un sistema de gestión de la calidad de los datos? ¿Qué criterios deben utilizarse para calificar la calidad de los datos? ¿Cuáles son los ejemplos de métricas de calidad de datos que son fáciles de aplicar? ¿Cuáles son las principales causas de los problemas de calidad de datos?

Trataremos cada una de estas cuestiones una por una. Esperamos que esta guía le ayude a crear o mejorar el proceso de auditoría de calidad de datos de su organización.

No realizar una auditoría puede tener consecuencias perjudiciales para su empresa

Las consecuencias de un mal control de la calidad de los datos

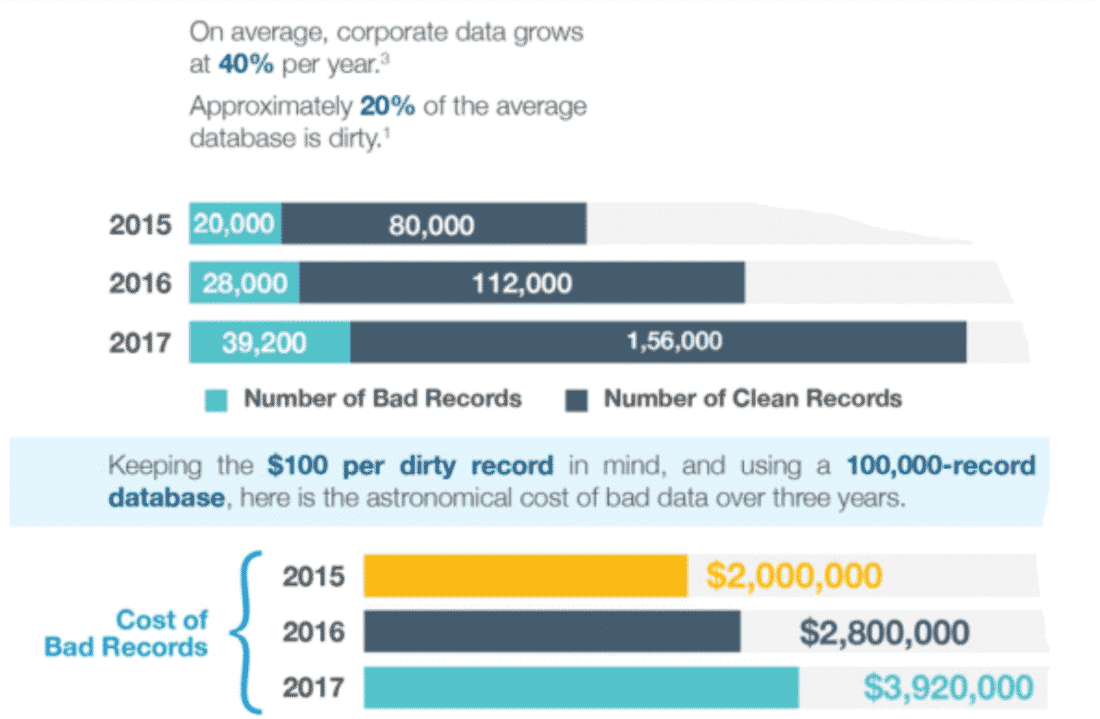

Un mal control de la calidad de sus datos puede tener consecuencias muy perjudiciales para su organización, a todos los niveles: el coste de sus campañas de marketing y su rendimiento, la comprensión de las necesidades y expectativas de sus clientes, la eficacia de sus procesos de venta (proceso lead-to-customer), la pertinencia de sus decisiones estratégicas, etc. RingLead ha publicado una infografía muy interesante sobre este tema. La empresa de software muestra los costes asociados a la mala calidad de los datos. He aquí un pequeño extracto de la infografía:

RingLead señala en primer lugar el asombroso crecimiento del volumen de datos de que disponen las empresas. Cada año, el volumen de datos aumenta un 40%. Pero el 20% de los datos son malos. Más adelante volveremos a hablar de los criterios para calificar la calidad de los datos. Los costes de utilizar datos de mala calidad aumentan año tras año. Otro estudio, de la conocida firma Gartner, nos dice que la falta de control de la calidad de los datos cuesta a las empresas encuestadas una media de ¡14 millones de dólares al año!

Los costes intangibles de un mal control de la calidad de los datos

No controlar la calidad de los datos es muy caro desde el punto de vista material y financiero. Esto es obvio. Pero junto a estos costes “tangibles”, también hay que tener en cuenta todos los costes intangibles, difíciles de medir por definición, pero bastante fáciles de imaginar.

Supongamos que su empresa quiere difundir una cultura basada en los datos. Usted hace todo lo posible y desarrolla un programa piloto para demostrar los beneficios del retorno de la inversión en la toma de decisiones basada en datos y en la inteligencia y el análisis empresarial. Pero el problema es que si sus datos no son de buena calidad, le resultará muy difícil demostrar las ventajas de la inteligencia empresarial a sus empleados y superiores. Si se cuestiona la calidad de los datos utilizados a posteriori, ya es demasiado tarde, sonará a excusa. Es mejor abordar los problemas de calidad de los datos y demostrar por adelantado la importancia crítica de contar con datos de alta calidad para generar un retorno de la inversión a partir de los datos.

El principal coste intangible: la mala toma de decisiones

Tal vez no le interese este ejemplo. Tal vez no sea necesario demostrar a los demás la importancia de integrar el análisis de datos en el proceso de toma de decisiones. Tal vez su empresa ya esté realizando análisis, pero sin prestar mucha atención al control de calidad de los datos. Pues bien, en ese caso, usted y su organización pueden enfrentarse a un problema aún mayor: tomar decisiones basadas en datos incorrectos. En cierto sentido, es mejor no basarse en los datos y utilizar la intuición que basarse en los datos sin controlar la calidad de los mismos. En este último caso, el impacto de las malas decisiones tomadas puede ser catastrófico. Por ejemplo, digamos que sus datos son incorrectos y muestran que su flujo de caja está en verde. Se le anima a desarrollar nuevas acciones y a aumentar sus inversiones. Salvo que, al cabo de unos meses, te das cuenta de que tienes graves problemas de liquidez. Salvo que sea un poco tarde, no puede pagar a sus proveedores ni tampoco a sus empleados. Comprobar la calidad de sus datos puede ayudarle a evitar estos problemas.

Un círculo virtuoso para garantizar la calidad de sus datos

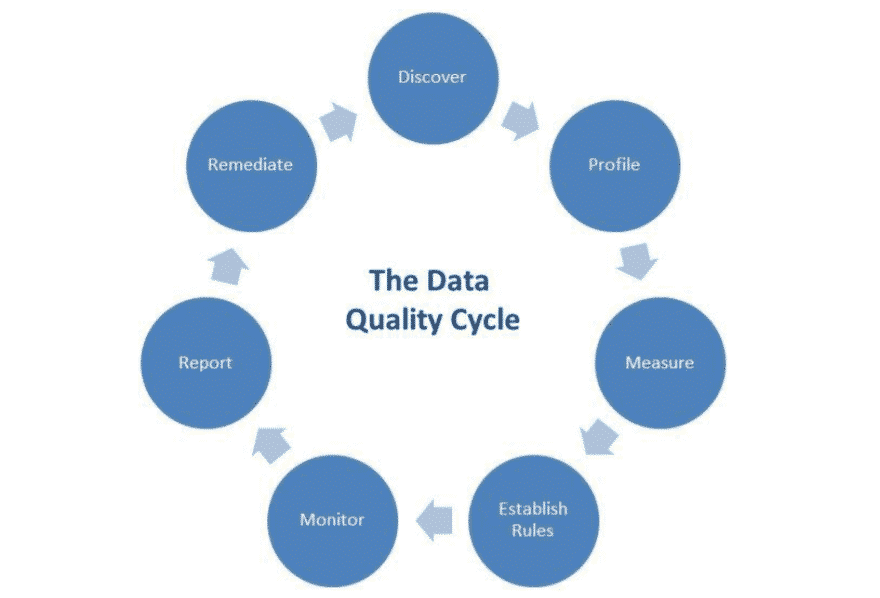

La gestión y el control de la calidad de los datos es un proceso continuo que puede ilustrarse como un ciclo:

He aquí las diferentes etapas resumidas en pocas palabras:

- Descubrimiento de datos => Métodos que facilitan la interpretación de los datos brutos por parte de usuarios no técnicos (vendedores, etc.). La visualización de los datos es una parte integral de esta etapa.

- Perfilado de datos => Proceso de análisis detallado de los datos, comparación de los datos con sus metadatos, cálculo de estadísticas y evaluación de la calidad de los datos y su evolución.

- Reglas de calidad de los datos => En función de las necesidades de la empresa, el proceso de definición de las reglas que deben seguir los datos para calificarse como datos de buena calidad.

- Control => Proceso de control continuo de la calidad de los datos sobre la base de las normas de calidad definidas anteriormente. Esto incluye, por ejemplo, la implantación de sistemas de notificación que permiten ser alertados cuando un dato cae por debajo del umbral de calidad.

- Elaboración de informes => Actividad de creación de cuadros de mando y aplicación de KPI para controlar la evolución de la calidad de los datos a lo largo del tiempo.

- Remediación => El proceso de corrección de errores y problemas reportados en los tableros.

Sólo este ciclo merecería un largo desarrollo. Aquí nos centraremos en 5 dimensiones de la calidad de los datos que debe tener en cuenta en su proceso de auditoría.

5 dimensiones clave para establecer su sistema de auditoría

Para medir la calidad de los datos, es evidente que se necesitan criterios de calidad. Hay que definirlos claramente de antemano. Estas dimensiones abarcan diferentes aspectos de la calidad. Hay 5 dimensiones principales que califican la calidad de los datos: exactitud, coherencia, exhaustividad, integridad y puntualidad.

Precisión

El primer criterio es el más obvio: ¿reflejan los datos la realidad? ¿Son correctas, válidas? ¿Describen con exactitud lo que dicen representar? Los cambios en el estado de los usuarios/clientes o en las transacciones contribuyen a la evolución continua de los datos y deben integrarse en su conjunto de datos en tiempo real. La precisión de los datos puede medirse a partir de fuentes documentales (por ejemplo, su software de gestión de pedidos) o mediante técnicas de confirmación. El objetivo es evaluar si sus datos contienen o no errores.

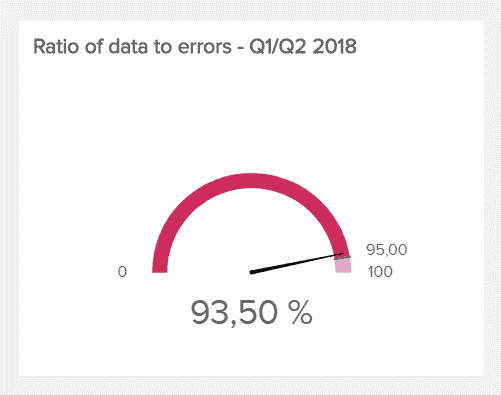

Una métrica comúnmente utilizada para medir la precisión de los datos es el ratio de precisión de los datos, es decir, el porcentaje de datos correctos. Cuanto más alta sea esta proporción, mejor, obviamente. No hay un ratio medio ni un ratio objetivo. Todo depende de su empresa, su tamaño, el volumen y el tipo de datos procesados. En la mayoría de los casos, una proporción superior al 85% se considera muy buena.

Coherencia

En sentido estricto, la dimensión de consistencia permite especificar si dos datos situados en dos bases de datos diferentes entran en conflicto o no. Se trata de saber si los datos dispersos en sus diferentes bases de datos son coherentes entre sí, si por ejemplo la información de un mismo individuo registrada en varias bases de datos es la misma. Sin embargo, en términos más generales, la coherencia no implica necesariamente precisión. Tomemos el ejemplo de establecer una regla que compruebe automáticamente si la suma de los empleados de cada departamento no supera el número total de empleados de la organización.

Completitud

¿Dispone de todos los datos necesarios para sacar las conclusiones correctas? ¿Se han rellenado correctamente todos los campos y atributos? ¿Hay campos vacíos? ¿Le faltan datos? Estas son las cosas que este criterio está diseñado para medir. La falta de exhaustividad de los datos puede distorsionar los resultados de sus análisis. Por tanto, es esencial tener en cuenta esta dimensión. Un ejemplo de métrica de calidad de datos que puede utilizar para evaluar este criterio es el número de campos vacíos en un conjunto de datos determinado.

Integridad

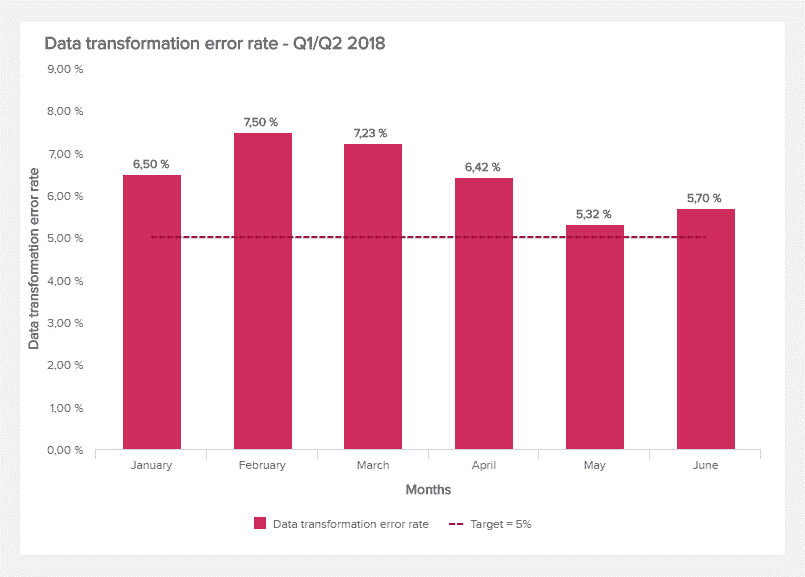

También conocida como validación de datos, la integridad se refiere a las pruebas y procedimientos diseñados para deshacerse de los errores y anomalías encontrados. Se trata de garantizar que los datos sean legibles y estén correctamente formateados (por ejemplo, que todas las fechas estén en formato DD/MM/AAAA). La tasa de error de transformación de datos puede utilizarse para medir la proporción de errores que se producen en las operaciones de transformación de datos (conversión de un formato a otro). Esta proporción puede controlarse a lo largo del tiempo.

Actualidad (o frescura)

Esta última dimensión consiste en garantizar que los datos estén disponibles y accesibles en todo momento. Este criterio mide el tiempo que transcurre entre el momento en que se solicitan los datos y el momento en que están realmente disponibles para su uso. El tiempo de obtención de los datos puede utilizarse para medir esta dimensión. El objetivo es reducir al máximo este tiempo, buscando un ideal de inmediatez.

Independientemente de cómo mejore la calidad de sus datos, siempre tendrá que medir la eficacia de sus esfuerzos. Estos ejemplos de métricas de calidad de datos le permiten supervisar y evaluar su trabajo. Cuanto más se mida, más se evalúe, más fácil será mejorar la calidad de los datos.

Ejemplos de métricas de calidad de datos que puede aplicar

Las dimensiones que hemos presentado anteriormente le permiten medir la calidad de sus datos y sus esfuerzos desde un punto de vista cuantitativo. Las métricas de calidad de datos que vamos a presentar ahora le permitirán adoptar paralelamente un enfoque más cualitativo. He aquí algunos ejemplos:

- Indicadores de satisfacción, obtenidos a través de encuestas o sondeos, que permiten medir la satisfacción de sus empleados con los datos de que disponen.

- Indicadores de productividad, como la evolución del porcentaje de veces que el departamento de gobierno de datos detecta y elimina proyectos o iniciativas redundantes.

- La medición de riesgos y oportunidades. Por ejemplo, los beneficios generados por la calidad de los datos o los riesgos materializados por el uso de datos problemáticos.

- Avances en el análisis de la competencia relacionados con una mayor disponibilidad de datos o mejoras en su calidad.

3 fuentes de problemas de calidad de datos

Es muy importante limpiar los datos, corregir los errores, completar los datos que faltan y comprobar la exactitud de los datos. Pero, como en todas partes, más vale prevenir que curar, identificando los problemas en sus raíces. Solucionar los problemas en su origen le ayudará a evitar datos de baja calidad. No olvide nunca que mantener la calidad de los datos no es un trabajo de una sola vez. Es un proceso continuo e interminable.

Fuente #1: Fusiones y adquisiciones

Cuando dos empresas se unen, ya sea por fusión (una entidad es absorbida por la otra) o por adquisición (una es absorbida por la otra), los datos siguen el mismo patrón y se ponen en contacto o incluso se fusionan. Al igual que cuando se juntan dos personas que han tenido hijos de una unión anterior, pueden surgir complicaciones. Por ejemplo, es posible, e incluso probable, que las dos empresas utilicen sistemas de datos completamente distintos, métodos de recogida de datos diferentes. Incluso es posible que una de las entidades tenga una base de datos llena de errores. Es aconsejable establecer una matriz de ganadores y perdedores que le permita decidir, en cada entrada de datos, cuál debe ser considerada como “verdadera”. Este tipo de matriz puede, por supuesto, ser muy compleja e incomprensible.

Si se enfrenta a esta situación, si está a punto de producirse una fusión o adquisición, reúna al departamento de TI en torno a la mesa para anticiparse a las futuras dificultades y formular un plan de acción de antemano, incluso antes de la firma.

Fuente #2: Migración de un sistema de información a otro

Para un usuario no técnico, puede ser complicado entender las dificultades inherentes al cambio de sistemas informáticos. Sin embargo, es una operación muy compleja. La transición de un sistema a otro puede ser muy complicada.

Algunas empresas llevan décadas utilizando los mismos sistemas de gestión de bases de datos. Para estas empresas, el momento de la migración suele ser muy difícil. Esto está relacionado con las características técnicas de los sistemas de información. Un sistema informático consta de tres partes:

- Una base de datos (= los datos).

- Las reglas establecidas y utilizadas para interpretar los datos

- La interfaz de usuario, que determina cómo se presentan los datos a quienes los manejan (los usuarios).

Cada uno de estos tres aspectos puede causar dificultades al migrar de un sistema informático a otro. La atención suele centrarse en la estructura de datos. Nos aseguramos de que esta estructura se mantenga. Este es un enfoque equivocado, porque las reglas de funcionamiento suelen ser muy diferentes de un sistema informático a otro. El resultado es que, tras la migración, los datos son incorrectos a ojos de los usuarios, aunque sigan siendo correctos desde un punto de vista estrictamente técnico.

Nuestro consejo: en el contexto de una migración, no basta con que su equipo de transición sea experto en uno u otro sistema, sino que debe estar muy familiarizado con ambos para garantizar una transición sin problemas.

Descubra nuestra comparación de bases de datos B2B.

Fuente #3: Errores del usuario

Se trata de un problema que probablemente nunca se resolverá del todo, ya que siempre habrá humanos introduciendo datos y el error es humano. Todo el mundo comete errores tipográficos con regularidad. Hay que reconocerlo y tenerlo en cuenta. Incluso los expertos encargados de la limpieza de datos cometen errores tipográficos. Si no podemos convertir a las personas en robots infalibles, nuestro consejo más sencillo es crear formularios fáciles de rellenar. De este modo, se pueden reducir considerablemente los errores de escritura.

En un momento de explosión del volumen de datos utilizados por las empresas, en una época de Big Data y de multiplicación de los puntos de contacto entre la empresa y sus clientes/usuarios, establecer un mecanismo de gestión de la calidad de los datos es una tarea esencial. Esperamos que esta guía haya arrojado algo de luz sobre algunos puntos y haya dado respuesta a las preguntas que pueda tener.