La qualité des données est devenue aujourd’hui un levier incontournable pour le développement de l’activité d’une entreprise.

Les gains à tirer d’une gestion efficace, compréhensive et suivie de la qualité de vos données sont énormes, et souvent insoupçonnés. Différents outils existent sur le marché pour répondre à ces différents besoins de traitement, mise à jour et nettoyage.

Quel que soit le type de solution choisi, le plus important reste de connaître les bonnes pratiques en data quality et de pouvoir mener régulièrement un audit de performance de la gestion de ces données.

La réalisation d’un tel projet passe par différentes phases : choix des dimensions qualitatives à traiter et sélection des critères permettant de les évaluer, cahier des charges, choix des outils d’analyse appropriés, structuration par étapes de la démarche qualité et réalisation périodique d’audits de contrôle.

Nous vous proposons ici un guide complet pour tous ceux qui souhaitent en apprendre davantage sur ces enjeux. Quelques heures de lecture suffisent pour faire le tour du sujet, et découvrir comment améliorer rapidement et sûrement la qualité de vos données.

Besoin d’accompagnement ?

Doublons, informations obsolètes, données manquantes…Les anomalies dans les bases marketing/CRM ont des conséquences bien réelles : des campagnes moins performantes, des analyses et des décisions biaisées…Pourtant, rares sont les entreprises qui ont mis en place une vraie démarche de Data Quality.

Heureusement, des solutions existent pour y remédier. Cartelis, un cabinet de conseil data à taille humaine, aide les entreprises à prendre ces sujets à bras le corps. Si vous avez des enjeux de Data Quality, on vous recommande de prendre contact avec eux. Ils font du très bon boulot. Ils pourront vous aider à tous les niveaux : audit, plan d’actions, mise en oeuvre opérationnelle, pilotage.

Sommaire

#1 Data Quality – Définition & Avantages

Si l’expression a aujourd’hui le vent en poupe, il n’est pas rare que certains éléments clés de sa définition soient méconnus au sein même des équipes marketing. Aussi, à moins d’être expert sur le sujet, comprendre la notion de “qualité des données” dans son intégralité est indispensable, notamment pour saisir l’ensemble des avantages opérationnels et financiers qui en découlent.

#2 Optimiser votre Data Quality Management – passage en revue des bonnes pratiques !

Garantir dans la durée une qualité optimale repose en priorité sur une gestion efficace, documentée et méthodologiquement structurée de vos données. En amont, certains leviers stratégiques peuvent être actionnés par vos équipes pour faciliter la mise en place de ces processus. Les 6 règles d’or du data quality management complètent ce corpus pour vous assurer que vous démarrez votre projet sur les bonnes bases.

#3 Choix des outils / prestataires en data quality

Il existe plusieurs moyens d’améliorer la qualité de vos données. Bien évidemment, vous pouvez le réaliser vous même ou bien choisir de passer par un prestataire extérieur. Tout dépend de la complexité de votre projet et du temps / budget à votre disposition. Le marché des outils de suivi/gestion en qualité des données compte maintenant de nombreuses solutions (Open source et propriétaires), et choisir la bonne solution pour votre projet nécessite un vrai travail de cadrage de vos besoins.

#4 Audits réguliers: l’assurance de données de qualité sur le long-terme

Jalon essentiel de votre démarche qualité, l’audit permet de vous assurer à intervalles réguliers que la qualité de vos données est maintenue à mesure que votre activité se développe ou que vous intégrez de nouveaux outils à votre portefeuille de solutions.

Les meilleures pratiques en Data Quality

Avec l’explosion du volume de données à disposition et le rôle croissant joué par la donnée dans les prises de décision stratégiques, la mise en place d’un Data Quality Management solide devient un chantier incontournable. D’autant que l’utilisation de données de mauvaise qualité entraîne des coûts considérables pour les entreprises.

Dans ce guide, nous allons vous donner des conseils et vous partager des bonnes pratiques pour vous aider à gérer au mieux la qualité de vos données.

Quels leviers stratégiques actionner pour améliorer la qualité de vos données ?

Plusieurs approches stratégiques ont fait leurs preuves et sont mis en oeuvre au sein des entreprises reconnues pour la qualité de leur management de la Data Quality. Tous les leviers que nous allons vous présenter ressortent d’une démarche pro-active de contrôle et de pilotage de la Data Quality, largement préférable aux approches “réactives” consistant à réparer le mal une fois qu’il est fait.

#1 Confier le management de la Data Quality aux équipes business

L’objectif principal de la donnée est d’alimenter le business. La donnée est le carburant du marketing, des sales, de la relation clients. Le management de la Data Quality, pour ces raisons, ne doit pas être confié à la DSI mais aux business units qui sont les principales utilisatrices des données.

Ces utilisateurs sont plus qualifiés pour déterminer les paramètres en matière de qualité des données, les données à collecter, les flux de données à créer, et identifier les données les plus importantes, celles dont la qualité doit être suivie de très près.

#2 Nommer des Data Stewards

Le Data Steward est la personne chargée de l’organisation et de la gestion des données de l’entreprise. Son objectif principal est de garantir la qualité et l’intégrité des données stockées dans le système d’information. Il est fortement conseillé de choisir un Data Steward parmi les business units, connaissant leurs enjeux, leurs besoins spécifiques et leur fonctionnement.

Nommer des Data Stewards permet de limiter à leurs racines les risques de dégradation de la Data Quality.

#3 Instituer un conseil de gouvernance des données

Ce groupe doit être composé de représentants des différentes fonctions de l’entreprise, de parties prenantes de la donnée et de représentants de la DSI. Les Data Stewards peuvent être en lien étroit avec les membres du conseil, ou même être nommés membres à part entière du conseil.

L’un des principaux objectifs de cette institution est de fixer des approches et des politiques en matière de Data Quality et de s’assurer qu’elles sont effectivement et correctement mises en place à travers toute l’entreprise.

Le conseil se réunit à intervalle régulier pour analyser les résultats en matière de gouvernance des données, prendre des mesures en cas de problèmes / d’erreurs et déterminer de nouvelles cibles de qualité.

#4 Mettre en place un pare-feu pour contrôler la qualité des données entrantes

Pour une entreprise, la donnée peut être assimilée à un actif financier, il est donc tout à fait logique de mettre en place des contrôles pour s’assurer que les données qui entrent dans le système d’information sont d’une qualité suffisante.

Il importe aussi que ces contrôles s’appliquent à chaque export ou modification de données dans la mesure où ces traitements peuvent entraîner une perte de “précision” des données. Comme nous l’avons expliqué ailleurs, utiliser des données de mauvaise qualité peut, en aval, causer de graves problèmes et avoir des impacts business très délétères.

Mettre en place un pare-feu virtuel permet de détecter et de bloquer les mauvaises données avant leur entrée dans le système d’information. Les données corrompues identifiées par le firewall peuvent soit renvoyées à leur source d’origine pour être modifiées, soit être rectifiées avant leur entrée.

Certaines solutions de management de la Data Quality propose des pare-feux aux règles personnalisables.

Les règles d’or avant de vous lancer dans un projet Data Quality

Avant de vous proposer quelques étapes à suivre pour améliorer votre système de management de la Data Quality, nous tenions à vous rappeler quelques règles essentielles en la matière. La mise en pratique de ces règles est la condition sine qua non pour implémenter une démarche efficace. Sans plus attendre, voici ces règles :

- Commencez petit. Start Small comme disent les anglo-saxons. Vous devez dès le départ avoir une vision claire de votre dispositif de Data Quality Management, mais vous devez adopter une démarche progressive. Ne cherchez pas à tout faire en même temps. Hiérarchisez les chantiers de déploiement et ordonnancez-les dans une roadmap claire.

- La Data Quality est un processus permanent. Un projet de management de la Data Quality n’est pas un projet one-shot, mais un processus permanent destiné à s’inscrire dans la durée et à évoluer avec elle. Un projet de Data Quality Management suppose un changement de culture de votre organisation en matière de gouvernance des données. Cela prend du temps. Vous serez amené à plusieurs reprises à faire évoluer votre dispositif dans une démarche d’amélioration continue.

- Focalisez-vous sur les objectifs et cibles de qualité. Vous devez identifier les critères et les métriques importants pour votre organisation. Quels critères doivent respecter vos données pour être qualifiées de données de qualité (précision, cohérence, intégrité, actualité…) ? Quels KPIs utiliser pour mesurer l’évolution de ces critères ?

- Priorisez vos actions en fonction du ROI estimé. Vous devez cibler en priorité les zones de douleur, les problèmes en matière de Data Quality susceptibles, par leur résolution, de délivrer le ROI le plus important. Cette règle se combine avec la précédente. Ce sont ces actions que vous devez déployer en premier.

- Il n’y a jamais qu’un seul chemin. Les données traversent l’entreprise de toute part, elles s’alimentent à de nombreuses sources / applications, coulent à travers de nombreux services d’intégration, viennent alimenter de nombreuses bases. Le management de la Data Quality peut se réaliser à partir de n’importe quel niveau dans vos flux de données, cela dépend de vos règles en matière de gouvernance des données, de vos besoins business, des règles de propriété des données, de l’architecture de vos systèmes, etc. Il y a bien souvent plusieurs choix sur la table permettant de mettre en oeuvre un management efficace de la Data Quality. Il n’y a jamais qu’une seule voie.

Optimiser votre Data Quality management en 5 étapes

Le management de la Data Quality est un processus qui se présente sous la forme d’un cercle et qui implique plusieurs phases d’implémentation. Voici les 5 étapes principales du processus. Ces étapes sont successives. Pour chacune d’elles, nous vous donnons quelques conseils spécifiques.

#1 L’évaluation de la qualité des données (Data Quality Assessment)

La première étape consiste à soumettre toutes les données stockées par l’entreprise à un travail d’inspection détaillé afin d’identifier les zones problématiques (erreurs, incohérences, données dupliquées, champs vides) qui nuisent à la poursuite des objectifs business de l’entreprise.

Il est conseillé, pour cette étape, de faire appel à un tiers extérieur à l’entreprise, qui saura poser un diagnostic objectif sur la situation actuelle. Cette première étape est la base à partir de laquelle toute la démarche de management de la Data Quality pourra se déployer.

Elle permet d’identifier les axes d’amélioration, les chantiers de travail, les actions à mener.

Nous conseillons de mixer :

- Une approche top-down, qui consiste à partir des pain points au niveau de l’activité et de rechercher leurs causes au niveau de la qualité des données.

- Une approche bottom-up, qui consiste une analyse des données qui permettra d’identifier les anomalies ayant un impact négatif sur la poursuite des objectifs de l’entreprise.

Ce travail se matérialise par la production d’un rapport listant de manière claire et précise tous les enseignements mis au jour. Ce rapport doit, dans la mesure du possible, être partagé à toutes les parties prenantes. C’est le support de base qui permettra de hiérarchiser et d’ordonnancer les chantiers d’actions prioritaires.

Découvrez notre Top 10 des outils de nettoyage de mailing listes.

#2 La mesure de la qualité des données

Le rapport produit lors de l’analyse permet de se focaliser sur les données les plus critiques, celles dont la qualité importe au plus haut point.

Vous devez déterminer des attributs et des dimensions (précision, cohérences, fraîcheur, intégrité, complétude) permettant de mesurer la qualité de ces données, définir des indicateurs (taux de données incomplètes par exemple) et des paliers de qualité (au-dessus desquels une donnée peut être qualifiée de donnée de qualité).

Vous pourrez en déduire les outils et les techniques à déployer pour atteindre le niveau de qualité requis sur les données cibles. Un tableau de bord peut être mis en place pour chaque business unit à partir des métriques et des paliers choisis.

#3 Identifier les lieux de contrôle des données

Lorsque l’on développe une application ou que l’on met à jour un système d’information, on commence en général par se focaliser sur la fonctionnalité avant de faire du management de la Data Quality.

Le fait d’avoir défini en amont les Data Quality metrics vous permettra d’intégrer les objectifs de Data Quality dès le départ, c’est-à-dire dans le cycle de développement des fonctionnalités et d’implémentation des outils. C’est de loin l’approche la plus efficace, car les personnes responsables du déploiement des fonctionnalités ont besoin de savoir quelles sont les données nécessaires pour chaque application.

Une bonne connaissance de la structure des flux de données à travers toutes les applications du système d’information permet d’identifier les lieux les plus pertinents pour l’inspection et les contrôles quotidiens. Il s’agit, presqu’à chaque fois, des lieux d’entrée des données dans le système.

C’est à partir de ce travail d’identification des points de contrôle que vous pourrez déduire les fonctionnalités cibles que vous devrez implémenter.

#4 L’amélioration de la Data Quality dans les systèmes d’information

Les données qui sont partagées entre les fournisseurs de données et les consommateurs doivent faire l’objet d’accords contractuels définissant clairement des niveaux de qualité acceptables.

Vous pouvez exploiter les Data Quality metrics que vous avez définis pour les incorporer dans les contrats de service. Définir des standards de qualité et de formats contribue à faciliter les flux de données d’une entité à l’autre.

Les meta-données peuvent être placées dans un registre destiné au Data Center Management qui devra s’assurer que les données sont représentées sous une forme acceptable et bénéfique pour les deux parties. C’est au Data Center Management qu’il revient d’opérer les analyses d’écart et l’alignement des besoins business des deux parties.

Les inspections de la qualité des données peuvent être réalisées manuellement ou via des process automatisés permettant de vérifier le niveau de qualité. Le monitoring et les actions correctrices peuvent être réalisés périodiquement, à une fréquence déterminée dans le contrat de servuce.

#5 Identifier les cas où les standards de Data Quality ne sont pas respectés et apporter les actions correctrices nécessaires

Lorsque vous identifiez une donnée qui ne respecte pas les niveaux de qualité attendus, les actions correctrices doivent être opérées par des mécanismes de tracking de la Data Quality semblables aux systèmes de tracking d’erreurs qui existent dans le secteur du développement de logiciels.

Le reporting des erreurs et le tracking des actions réalisées pour les corriger peuvent aider à nourrir les rapports de performance. L’important est que l’analyse ne doit pas seulement reposer sur les erreurs, mais aussi sur leurs causes.

C’est de cette manière que vous parviendrez à identifier les défauts au niveau de vos process. A cela doit s’ajouter un nettoyage pro-actif des données à intervalle régulier pour identifier des erreurs passées sous le radar ou introduites dans le système malgré les contrôles.

Il est important que le management de la Data Quality s’opère au plus haut niveau de l’organisation, en utilisant des outils appropriés de data management afin de faciliter la mesure, le reporting et le process d’amélioration continue.

La solution retenue doit également être en mesure de s’aligner avec les objectifs business de l’entreprise, forcément singuliers.

Les objectifs de Data Quality et les plans de gestion doivent être partagés entre les producteurs, les consommateurs, les développeurs et les opérationnels.

La Data Quality concerne tout le monde, et pas simplement une fonction de l’entreprise. Elle doit devenir une culture d’entreprise. Les process de saisie des données doivent être fixés clairement au plus haut niveau de l’organisation.

Pour résumer

Une gouvernance des données réussie commence par la mise en oeuvre d’une stratégie de gestion de la qualité des données efficace.

Cela passe par le choix et l’implémentation d’une solution technologique appropriée. Le choix de la solution est une étape déterminante – il doit être dicté par les besoins fonctionnels de l’entreprise. Une autre clé, selon nous, pour un management solide de la Data Quality consiste à mettre en place un groupe dédié, comprenant aussi bien des représentants de la DSI que des utilisateurs des données.

Ce sont d’ailleurs ces utilisateurs, ceux qui transforment les données en actions génératrices de revenus, qui doivent piloter ce groupe et non les techniciens. Un projet de management de la Data Quality a donc bien un double versant : humain et technologique.

Les meilleurs outils pour votre data quality

La qualité de la donnée (ou data quality) fait référence aux critères et aux processus utilisés pour mesurer ou améliorer la qualité des données. Dans cette optique, de nombreux outils sont disponibles pour gérer, préparer et vérifier la donnée, avec chacun leurs spécificités. Nous avons listé pour vous une sélection des meilleures solutions pour vous permettre d’améliorer la qualité de vos données disponibles et exploiter pleinement leur potentiel.

#1 Data Management (dont Data Quality) – Plutôt grandes entreprises

La gestion des données ou data management est décrit par beaucoup comme un des enjeu majeur de notre siècle. La croissance exponentielle des données disponible représentent une source toujours plus importante d’informations.

L’enjeu est d’arriver à les exploiter de manière pertinente pour aider à la prise de décision des entreprises ou des organisations gouvernementales.

Ce besoin a donné naissance au data management, ou gestion de données. Ce terme comprend l’ensemble du processus d’acquisition, de validation, de stockage, de protection et de traitement des données dans le but de garantir l’accessibilité, la fiabilité et la récence des données pour ses utilisateurs.

Vous trouverez ici une liste des principaux outils les plus adaptés pour les grandes entreprises.

#1 SAS

SAS est un logiciel complet de data management qui permet la création et la gestion de bases de données, le traitements analytiques des bases de données et la création et diffusion de rapports de synthèse et de listing. De grandes entreprises l’utilisent comme Honda, Bank of America ou l’ONG WWF.

Points forts :

- Outils complet pour les grandes entreprises

- S’adapte à tous les secteurs d’activités

Prix :

- De 7 000€ /an pour les fonctionnalités basiques jusqu’à plusieurs centaines de milliers d’€/an

#2 Informatica

Informatica propose plusieurs solutions dédiées à l’intégration, l’analyse, et l’amélioration de la qualité des données. L’entreprise propose également des services de stockage des données dans le Cloud. Elle propose également une solution SaaS.

Points forts :

- Possibilité d’intégration à de nombreuses sources de données

- Facilité d’utilisation et maintenabilité.

Prix :

- En fonction du nombre de fonctionnalités.

#3 Melissa

Melissa est un outil dédié à la vérification des données (l’identité, l’adresse, le téléphone, l’email) indispensable pour garder un niveau de qualité de données élevés. Ils proposent également des services autour des données de localisation et de démographie.

Points forts :

- Peut être combiné avec d’autres outils internes (solution d’emailing, CRM…)

- Dispose de solutions SaaS

Prix :

- Sur demande

#4 Oceanos

Oceanos conçoit des des stratégies de gestion des données qui optimisent les performances commerciales et marketing. L’outil est intégrable à un fichier CRM et permet de scorer le niveau de qualité des données et de nettoyer, mettre à jour, enrichir et analyser les données.

Points forts :

- Nombreuses intégrations possibles (API, Zapier, Salesforce…)

Prix :

- De 1500$ à 9500$ par mois

#2 Data Preparation

La Data Preparation ou la préparation des données comprend l’ensemble des étapes de nettoyage des données permettant d’assurer leurs cohérences et leurs qualité. La préparation comprend par exemple la fusion de plusieurs sources de données, le filtrage de données inutiles, la consolidation, l’agrégation de données et le calcul de valeurs supplémentaires basées sur les données brutes. La préparation est importante quand on sait que des données incohérentes et de mauvaise qualité peuvent fausser les informations qui en découlent. Elles peuvent également rendre l’analyse et l’exploration de données lente et peu fiable. En préparant la donnée en amont, les entreprises sont plus à même d’exploiter au mieux son potentiel.

#5 Google Dataprep

Cloud Dataprep est un service visuel intelligent pour explorer, nettoyer et préparer des données à analyser fonctionnant sans serveur. Vous pouvez importer plusieurs fichiers, les fusionner, nettoyer, enrichir, standardiser…

Points forts :

- Simple d’utilisation

Prix :

- En moyenne 3€ par heure d’utilisation

#6 Talend Data Preparation

Talend Data Preparation est une solution permettant de préparer de la donnée avec 3 formules différentes : un logiciel gratuit et open source, un logiciel à télécharger payant et une solution cloud payante également.

Points forts :

- Une solution est possible pour chaque type de besoin

Prix :

- Sur demande

#7 Dataiku

Dataiku est un outil de data analyse, utilisable à la fois par les ingénieurs et par les marketeurs, performant pour la data preparation. L’interface est simple et interactive pour quelle soit simple d’utilisation par les marketeurs, et suffisamment avancé et technique pour plaire aux ingénieurs informatiques.

Points forts :

- Interface simple et intuitive à la fois pour les ingénieurs et pour les marketeurs

Prix :

- Une version basique gratuite

- Sur demande pour une version plus complète

#8 Qlik Sense

Qlik sense est un outil particulièrement adapté aux non-initiés. L’interface est très visuelle, et l’analyse est facilité par des suggestions automatiques. Son côté ludique rend accessible l’information à tous les métiers de l’entreprise. Vous pouvez visionner une démo de 60 secondes un regardant cette vidéo.

Points forts :

- Utilisable par tous les métiers de l’entreprise

- Interface simple et ludique

Prix :

- Une version basique gratuite

- Sur mesure pour plus de fonctionnalités

#9 WinPure

WinPure est une suite no-code et accessible d’outils de data quality qui est sur le marché depuis 15 ans. Ils proposent une solution très complète de services pour adresser les enjeux de data quality de clients de toutes tailles et industries.

Ils proposent aussi une solution de Master Data Management qui permet à leurs clients de mettre en place, tester, et déployer des initiatives MDM avant d’investir plus significativement dans l’infrastructure et le recrutement de talents.

Points forts :

- Solution très complète de data cleansing, matching et preparation

- Vérification d’addresses

- Master Data Management

Prix :

- À partir de 999$ par mois

#3 Vérification coordonnées

La vérification des coordonnées consiste à prendre tous les types de données sur les personnes physiques et les entités juridiques, puis à les analyser et à les normaliser dans un format correct et unique. Elle est liée à la préparation des données puisqu’elle a le même objectif d’obtenir des données fiables permettant un traitement sans erreurs.

#10 DataValidation

DataValidation est une solution de nettoyage d’emails parmi les plus performantes du marché. Elle va permettre de repérer les adresses mails invalides pour que vous ne soyez pas considéré comme spammeur lors de vos campagnes d’emailing.

Points forts :

- Simple d’utilisation

- Précision des résultats

Prix :

- 70$ pour 10 000 emails vérifiés, 300$ pour 100 000 emails

#11 76310

La solution 76310 est spécialisé sur le contrôle et la correction des adresses postales.Elle respecte la norme RNVP pour le traitement informatique de mise aux normes postales des adresses et est homologué par La Poste SNA (service national des adresses).

Points forts :

- Interface disponible pour le traitement RNVP

- Traitement RNVP, déménagement et logiciel de dédoublonnage

- Homologué SNA

Prix :

- Pour 10 000 adresses (utilisation en mode SaaS) – 200 €

- Pour 100 000 adresses (utilisation en mode SaaS) – 400 €

- Mise à disposition du logiciel on premise – de 16000 € HT / an à 30.000 € HT / an

#12 Egon

Egon est l’une des principales références au niveau des progiciels présents sur le marché international dans la normalisation des données personnelles diverses (nom, date de naissance, titres, numéros de téléphone, email, code fiscal, numéro de TVA, coordonnées bancaires, données postales, code postal, noms étrangers, pièces d’identité)

Points forts :

- Choix important de données à normaliser

- Solution complète de validation des données

Prix :

- Sur demande

Audit data quality

Si la donnée est le carburant de votre entreprise, en particulier de vos départements marketing & sales, encore faut-il que ces données soient de bonne qualité. Travailler sur des données de mauvaise qualité génère des coûts de toutes sortes et peut contribuer à prendre de mauvaises décisions stratégiques.

Comment mettre en place un dispositif de pilotage de la Data Quality ? Quels critères utiliser pour qualifier la qualité des données ? Quels sont les exemples de data quality metrics faciles à mettre en place ? Quelles sont les principales causes à l’origine des problèmes de Data Quality ?

Nous allons traiter toutes ces questions une après une. Nous espérons que ce guide vous aidera dans la construction ou l’amélioration de votre démarche d’audit de la qualité des données de votre organisation.

L’absence d’audit peut avoir des conséquences préjudiciables pour votre entreprise

Les conséquences d’un mauvais contrôle qualité des données

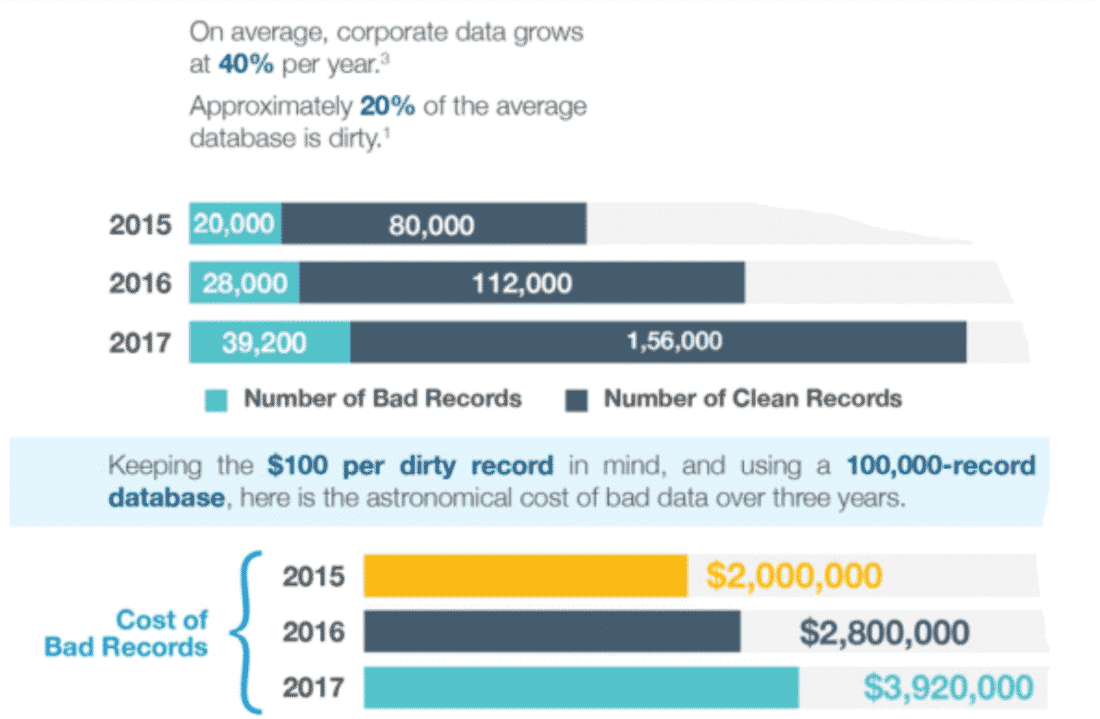

Un mauvais contrôle de la qualité de vos données peut avoir des conséquences très préjudiciables sur votre organisation, à tous les niveaux : le coût de vos campagnes marketing et leurs performances, la compréhension des besoins et attentes de vos clients, l’efficacité de vos process commerciaux (process de transformation de leads à clients), la pertinence de vos décisions stratégiques, etc. RingLead a publié une infographie très intéressante à ce sujet. L’éditeur de logiciels y montre les coûts associés aux données de mauvaises qualité. Voici un petit extrait de l’infographie :

RingLead souligne d’abord la croissance vertigineuse du volume de données à disposition des entreprises. Chaque année, le volume de données augmente de 40%. Mais 20% des données sont de mauvaises données. Nous reviendrons plus loin sur les critères qui permettent de qualifier la qualité des données.

Les coûts liés à l’exploitation de données de mauvaise qualité croît d’année en année. Une autre étude, du célèbre cabinet Gartner, nous apprend que le manque de contrôle-qualité des données coûte aux entreprises interrogées en moyenne 14 millions de dollars par an !

Les coûts intangibles liés à un mauvais contrôle-qualité des données

Ne pas contrôler la qualité de ses données coûte très cher d’un point de vue matériel et financier. C’est une évidence. Mais à côté de ces coûts “tangibles”, il faut aussi prendre en considération tous les coûts intangibles, difficiles par définition à mesurer mais assez faciles à imaginer.

Imaginions que votre entreprise cherche à diffuser une culture “data-driven”. Vous déployez tous les efforts nécessaires et développez un programme pilote destiné à montrer le bénéfice en termes de ROI des prises de décision data-driven, basées sur la business intelligence et l’analytics.

Mais, problème : si vos données ne sont pas de bonne qualité, vous allez avoir beaucoup de mal à démontrer à vos collaborateurs et à vos supérieurs les bénéfices de la Business Intelligence. Si vous mettez en cause la qualité des données utilisées après coup, c’est trop tard, ça sonnera comme une excuse.

Vous avez plus intérêt à régler les problèmes de Data Quality et à démontrer en amont l’importance cruciale de disposer de données de haute qualité pour générer du ROI à partir des données.

Le principal coût intangible : les mauvaises prises de décision

Peut-être que vous n’êtes pas concerné par cet exemple. Peut-être que vous n’avez pas besoin de démontrer aux autres l’importance d’intégrer l’analyse des données dans le process de prise de décision. Peut-être que votre entreprise fait déjà de l’analytics, mais sans pour autant prêter beaucoup d’attention au contrôle de la Data Quality.

Eh bien, dans ce cas, vous et votre organisation risquez d’être confrontés à un problème encore plus grave : celui de prendre des décisions en vous basant sur des données incorrectes. En un sens, mieux vaut ne pas être data-driven du tout et utiliser son intuition plutôt que d’être data-driven sans contrôler la qualité des données utilisées.

Dans ce dernier cas, l’impact des mauvaises décisions prises peut être catastrophique. Par exemple, mettons que vos données, incorrectes, montrent que votre trésorerie est dans le vert. Vous êtes incité à développer de nouvelles actions et à augmenter vos investissements.

Sauf qu’au bout de quelques mois, vous prenez enfin conscience que vous avez de graves problèmes de cashflow. Sauf qu’il est un peu tard, vous êtes incapable de régler vos fournisseurs, voire de payer vos salariés. Contrôler la qualité de ses données permet de se prémunir de ces difficultés.

Un cycle vertueux pour garantir la qualité de vos données

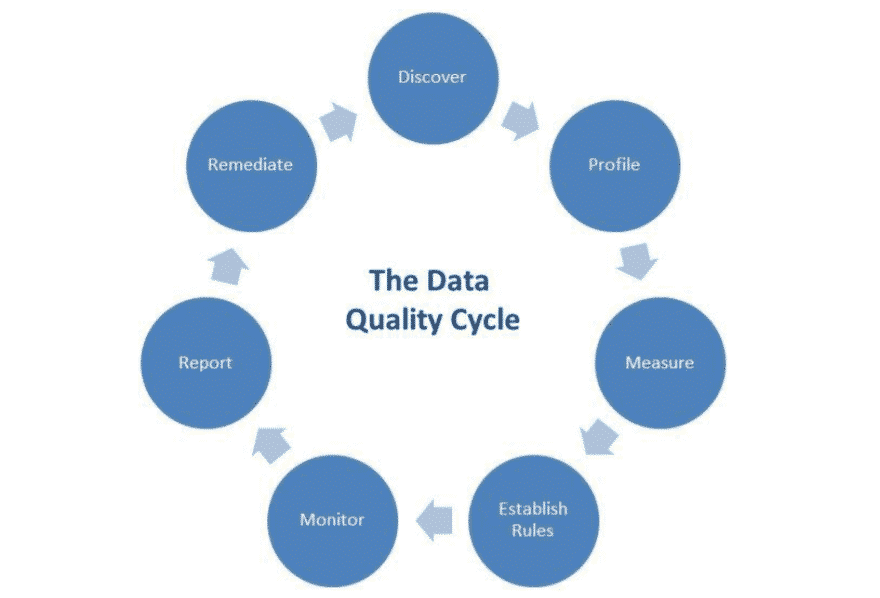

La gestion et le contrôle de la qualité des données est un processus continu qui peut s’illustrer sous la forme d’un cycle :

Voici les différentes étapes résumées en quelques mots :

- Data discovery => Méthodes qui permettent de faciliter l’interprétation des données brutes par des utilisateurs non-techniciens (marketers…). La Data Vizualisation est partie intégrante de cette étape.

- Data Profiling => Process qui consiste à analyser les données dans le détail, à comparer les données à leurs meta-données, à calculer des statistiques et à évaluer la qualité des données et son évolution.

- Data Quality Rules => En fonction des besoins business, le process qui consiste à définir les règles que les données doivent respecter pour pouvoir être qualifiées de données de bonne qualité.

- Monitoring => Le process de pilotage continu de la Data Quality sur la base des règles de qualité définies en amont. Ce qui inclut par exemple la mise en place de systèmes de notification permettant d’être alerté lorsqu’une donnée passe sous le seuil de qualité.

- Reporting => L’activité qui consiste à créer des tableaux de bord et à implémenter des KPIs pour suivre l’évolution de la qualité des données à travers le temps.

- Remediation => Le process qui consiste à corriger les erreurs et les problèmes tels qu’ils sont reportés dans les tableaux de bord.

Ce cycle mériterait à lui seul de longs développements. Nous allons ici nous concentrer en particulier sur 5 dimensions de la Data Quality que vous devrez prendre en compte dans votre démarche d’audit.

5 dimensions clés pour mettre en place votre dispositif d’audit

Pour mesurer la qualité de vos données, vous avez évidemment besoin de critères de qualité. Vous devez clairement les définir en amont. Ces dimensions recoupent différents aspects de la qualité. Il existe 5 principales dimensions qui permettent de qualifier la qualité des données : la précision, la cohérence, la complétude, l’intégrité et l’actualité.

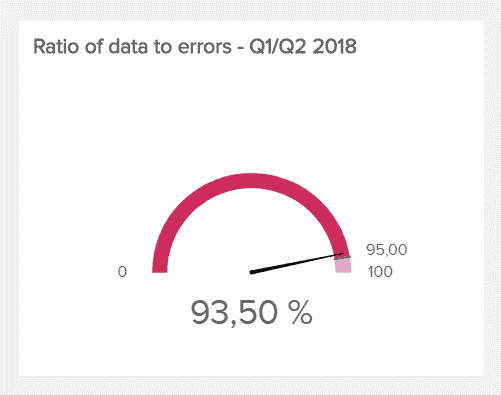

La précision (accuracy)

Le premier critère est le plus évident : vos données reflètent-elles la réalité ? Sont-elles correctes, valides ? Décrivent-elles précisément ce qu’elles prétendent représenter ? Les changements de statuts des utilisateurs / clients ou les transactions contribuent à faire évoluer en permanence les données et doivent être intégrés dans votre set de données en temps réel.

La précision des données peut être mesurée à partir de sources documentaires (votre logiciel de gestion des commandes par exemple) ou à l’aide de techniques de confirmation. Il s’agit d’évaluer si vos données comportent ou non des erreurs.

Une metrics utilisée couramment pour mesurer la précision des données est le taux de précision des données, c’est-à-dire le pourcentage de données correctes. Plus ce ratio est élevé, mieux c’est, à l’évidence. Il n’y a pas de ratio moyen ou de ratio cible.

Tout dépend de votre entreprise, de sa taille, du volume et du type de données traitées. Dans la plupart des cas, un ratio supérieur à 85% est jugé très bon.

La cohérence

Au sens strict, la dimension de cohérence permet de spécifier si deux données localisées dans deux bases différences entrent en conflit entre elles ou non. Il s’agit de savoir si les données dispersées dans vos différentes bases sont cohérentes entre elles, si par exemple les informations d’un même individu enregistré dans plusieurs bases sont les mêmes.

Cependant, plus largement, la cohérence n’implique pas forcément la notion d’exactitude. Prenons l’exemple de la mise en place d’une règle qui permettrait de vérifier automatiquement si la somme des employés dans chaque département n’excède pas le nombre total d’employés de l’organisation.

L’exhaustivité

Disposez-vous de toutes les données dont vous avez besoin pour tirer les bonnes conclusions ? Vos champs et vos attributs sont-ils tous correctement renseignés ? Y-a-t-il des champs vides ? Avez-vous des données manquantes ?

Ce sont ces choses qu’il s’agit de mesurer à travers ce critère. Le manque d’exhaustivité des données peut fausser les résultats de vos analyses. Cette dimension est donc essentielle à prendre en compte. Un exemple de data quality metrics que vous pouvez utiliser pour évaluer ce critère : le nombre de champs vides dans un data set donné.

L’intégrité

Aussi connue sous le nom de Data Validation, l’intégrité fait référence aux tests et aux procédures destinés à se débarrasser de toutes les erreurs et anomalies constatées. Il s’agit de s’assurer que les données sont bien lisibles et correctement formatées (par exemple, que toutes les dates se présentent sous le format JJ/MM/AAAA).

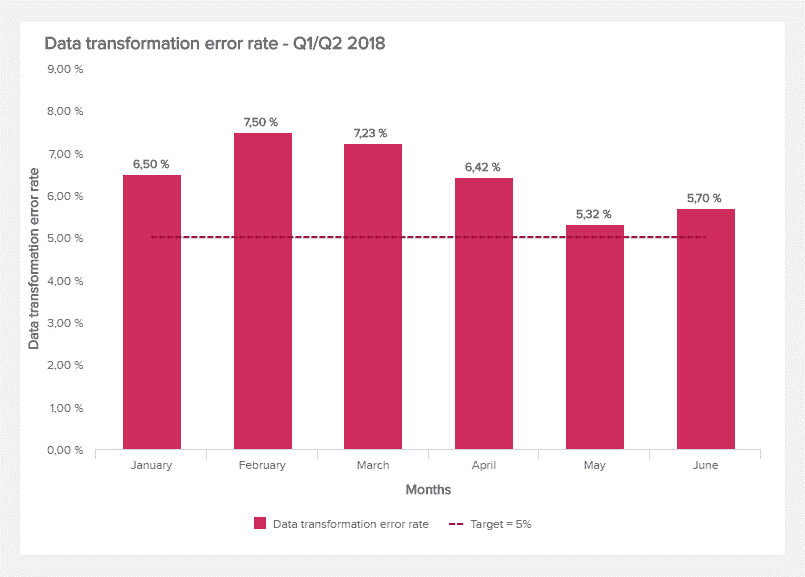

On peut utiliser le Data transformation error rate pour mesurer la proportion d’erreurs survenues dans les opérations de transformation des données (de conversion d’un format à un autre). On peut suivre l’évolution de ce ratio dans le temps.

L’actualité (ou la fraîcheur)

Il s’agit, à travers cette dernière dimension, de s’assurer que les données sont disponibles et accessibles à tout moment. Ce critère mesure le temps entre le moment où la donnée est demandée et où elle est effectivement disponible à l’usage. On peut utiliser le data time-to-value pour mesurer cette dimension. L’objectif est de réduire au maximum cette durée, en visant un idéal d’immédiateté.

Quelle que soit la manière que vous utilisez pour améliorer la qualité de vos données, vous aurez toujours besoin de mesurer l’efficacité de vos efforts. Ces exemples de data quality metrics permettent de suivre et d’évaluer votre travail. Plus vous mesurerez, plus vous évaluerez, plus il sera simple d’améliorer la Data Quality.

Exemples de data quality metrics que vous pouvez mettre en place

Les dimensions que nous avons présenté plus haut permettent de mesurer votre Data Quality et vos efforts d’un point de vue quantitatif. Les data quality metrics que nous allons vous présenter maintenant vous permettront d’adopter en parallèle une approche plus qualitative. Voici quelques exemples :

- Les indicateurs de satisfaction, obtenus par l’intermédiaire de sondages ou d’enquêtes, qui permettent de mesurer la satisfaction des collaborateurs de votre entreprise vis-à-vis des données à leur disposition.

- Les indicateurs de productivité, comme par exemple l’évolution du pourcentage de fois où le département en charge de la gouvernance des données détecte et élimine les projets ou initiatives redondants.

- La mesure des risques et des opportunités. Par exemple, les bénéfices générés grâce à la qualité des données ou les risques matérialisés liés à l’utilisation de données problématiques.

- Les progrès en matière d’analyse concurrentielle liés à une meilleure disponibilité des données ou aux améliorations au niveau de la qualité des données.

3 sources à l’origine des problèmes de mauvaise qualité des données

Nettoyer ses données, réparer les erreurs constatées, compléter les données manquantes, vérifier leur précision sont des choses très importantes. Mais, comme partout, mieux vaut prévenir que guérir, en identifiant les problèmes à leurs racines. Régler les problèmes à leur source vous permettra d’éviter la remontée de données de mauvaise qualité. N’oubliez jamais que maintenir la qualité des données n’est pas un travail one shot. C’est un processus continu et sans fin.

Source #1 : Les fusions et les acquisitions

Lorsque deux entreprises se rapprochent, qu’il s’agisse d’une fusion (absorption d’une des entités par l’autre) ou d’une acquisition (prise de contrôle de l’une par l’autre), les données suivent le même mouvement et sont amenées à entrer en relation, voire à fusionner. Comme lorsque deux personnes ayant eu des enfants d’une précédente union se mettent ensemble, des complications peuvent survenir.

Par exemple, il est possible, et même probable, que les deux entreprises utilisent des systèmes de données complètement différents, des méthodes de collecte de la donnée différentes. Il est même possible que l’une des entités aient une base de données remplie d’erreurs.

Il est conseillé de mettre en place une matrice winner-loser qui permette de décider, à chaque saisie de données, laquelle doit être considérée comme “vraie”. Ce genre de matrice peut, on s’en doute, s’avérer très complexe et incompréhensible.

Si vous êtes confronté à cette situation, si une fusion une acquisition est sur le point d’être réalisée, réunissez autour d’une table la DSI pour anticiper les difficultés à venir et formuler un plan d’actions en amont – avant même la signature.

Source #2 : Migrer d’un système d’information à un autre

Pour un utilisateur non-technique, il peut être compliqué de comprendre les difficultés inhérentes au fait de changer de système informatique. Pourtant, c’est une opération très complexe. La transition d’un système à l’autre peut s’avérer très délicate.

Certaines entreprises utilisent les mêmes systèmes de gestion de leurs bases de données depuis des décennies. Pour ces entreprises, le moment de la migration est souvent très mal vécu. Ceci est lié aux caractéristiques techniques des systèmes d’information. Un système informatique comprend trois parties :

- Une base de données (= les données).

- Les règles mises en place et utilisées pour interpréter les données

- L’interface utilisateur, qui détermine la manière dont les données sont présentées à ceux qui les manipulent (les utilisateurs).

Chacun de ces trois aspects peut faire naître des difficultés au moment de la migration d’un système informatique à l’autre. On se focalise en général sur la structure des données. On veille à ce que cette structure se conserve.

C’est une mauvaise approche, car d’un système informatique à l’autre, les règles de fonctionnement sont souvent très différentes. Résultat : Les données, après la migration, sont incorrectes aux yeux des utilisateurs alors même qu’elles peuvent rester correctes d’un point de vue strictement technique.

Notre conseil : dans le cadre d’une migration, ce n’est pas suffisant que votre équipe en charge de la transition soit experte de l’un ou l’autre des systèmes. il faut qu’ils connaissent très bien les deux systèmes pour que la transition se passe en douceur.

Découvrez notre comparatif des bases de données B2B.

Source #3 : Les erreurs des utilisateurs

C’est un problème que l’on ne pourra sans doute jamais régler entièrement. dans la mesure où il y aura toujours des humains pour réaliser de la saisie de donnée et que l’erreur est humaine. Tout le monde fait des fautes de frappe de manière régulière. Il faut l’acter et le prendre en considération.

Même les experts en charge du nettoyage de données font des fautes de frappe ! A défaut de transformer les hommes en robots infaillibles, notre conseil le plus simple est de créer des formulaires faciles à remplir. On peut, de cette manière, réduire significativement les erreurs de frappe.

A l’heure de l’explosion du volume de données utilisé par les entreprises, à l’heure du Big Data et de la multiplication des points de contacts entre l’entreprise et ses clients/utilisateurs, mettre en place un mécanisme de pilotage de la qualité des données est un chantier incontournable.

Nous espérons, par ce guide, vous avoir éclairé sur certains points et apporté des réponses à des questions que vous vous posiez.

Félicitations et merci pour cette article très complet !